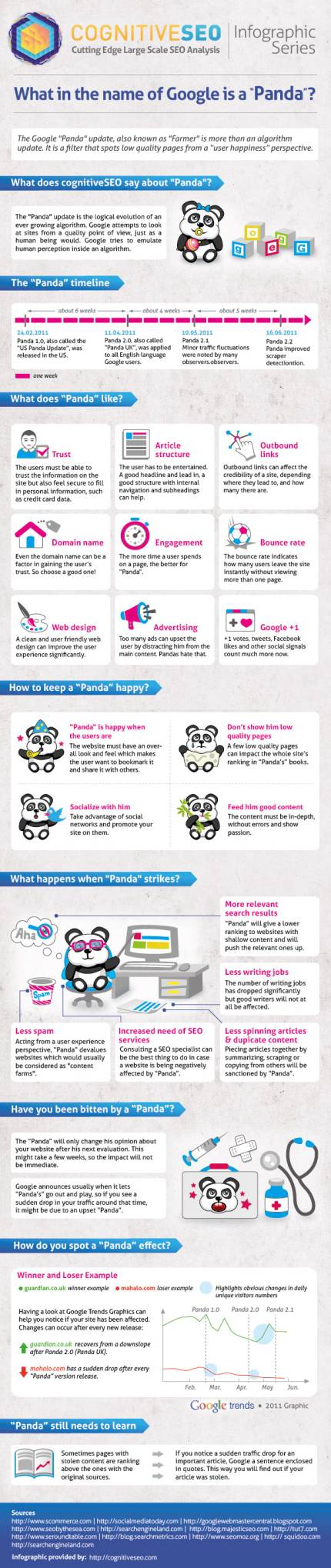

Es evidente que en los últimos 20 meses el panorama del posicionamiento en los buscadores (SEO Search Engine Optimization) ha cambiado dramáticamente. La propagación de la primera actualización de Panda el 25. de Febrero de 2011, una nueva clase de algoritmos del buscador Google, hicieron temblar al mundo SEO.

Para una relación de todos cambios más importantes de los algoritmos de Google se puede consultar aquí, aunque Google ha mencionado que anualmente se realizan más de 500 actualizaciones.

Con el uso de clasificadores y técnicas de inteligencia artificial la primera actualización de Panda en el espacio de habla inglesa, Google introdujo otro tipo de parámetros para calificar la calidad de una página: «La usabilidad de las páginas web, el contenido único y de valor para los usuarios, así como también varias métricas de uso.» (Sobre la actualización Panda de Google).

Adicionalmente a esta actualización que ya anda en su versión 20, Google lanzó más o menos el 24 de Abril de 2012 la actualización llamada Penguin (el llamado link and webspam algorithm que actualmente ya esta en su tercera 3 versión) y que tiene como objeto penalizar sitios con contenidos de baja calidad, con spam y una gran cantidad de enlaces.

Con Penguin se hizo realidad la pesadilla de los SEOs y webmasters: el SEO negativo, es decir ser penalizado por enlaces entrantes malos, o sea enlaces hacia el sitio desde webs con spam, granjas de enlaces etc. Así, de esta manera es posible hacer caer en el ranking del buscador a un sitio de la competencia sin muchos esfuerzos. Lo cuál efectivamente ha sucedido y fue reportado en la blogsfera. Y justamente hace unos días atrás Google ha presentado una nueva herramienta para desautorizar o privar de autoridad a enlaces entrantes (ver nota en WebmasterTools) y que como indican «debe ser usada con mucho cuidado y solo en caso necesario».

Y para concluir el año 2012, Google recientemente ha propagado otro tipo de cambio: La actualización EDM (exact match domains) es decir que ahora también se penaliza a los dominios que tienen frases exactas de keywords en sus dominios.

Con esta gran avalancha de actualizaciones es comprensible ver a los SEO totalmente desconcertados. Solamente basta visitar los foros sobre el tema. Ahí nadie todavía ha encontrado una receta clara para poder contrarrestar todos estos nuevos algoritmos.

Antes, como las actualizaciones afectaban de igual manera a webs similares, era posible hacer cambios especificos para contrarrestar algún tipo de penalización. Adicionalmente, estos cambios eran más o medibles y se los podía verificar en los resultados del buscador en cuestión de días o semanas.

Ahora todo es diferente: No se puede saber con exactitud cual es la razón del porqué una web ha sido penalizada, ya que ahora también entran en juego muchos parámetros que son generados por los usuarios al visitar la web, como por ejemplo el tiempo de permanencia, el porcentaje de rebote, etc.

De ahí que el desconcierto de los SEOs es total! Pero bueno, la vida continua y quien que no lucha, ya ha perdido.

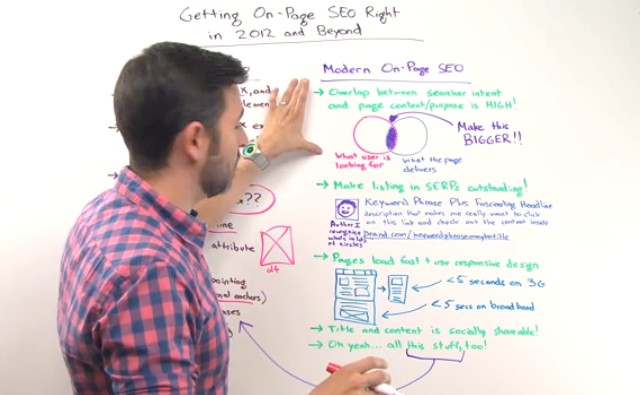

Justamente para poner en claro esta situación y ayudar a los SEOs a ver una pequeña luz al final del túnel, Rand Fishkin de SEOmoz ha presentado un vídeo en el que explica los nuevos aspectos que ahora se deben tomar en cuenta al momento de posicionar una web.

Se distingue entre un OnPage SEO clásico y el SEO de 2012 en adelante

OnPage SEO clásico

Se caracteriza por colocar:

- Palabras claves en el título de la página y al inicio del texto.

- Palabras clave repetidas varias veces en el texto para aumentar su densidad.

- Palabras clave en la URL.

- Palabras clave en los tags H1, H2, etc. o en negrita para realzar su relevancia en el contenido.

- Palabras clave en los metatags.

- Palabras clave en el atributo alt de las imágenes.

- Palabras clave en los enlaces que apuntan a páginas internas.

- Términos relacionados a las palabras clave en el texto.

Usando estas técnicas sencillas era posible subir relativamente fácil en las posiciones de los resultados del buscador. También si un usuario del buscador encontraba una de las palabras clave en los resultados hacia directamente clic suponiendo que ya había encontrado lo que buscaba y que la página contenía exactamente lo que necesitaba.

Pero ahora con todos los últimos cambios en el buscador, esto ya no es suficiente para un buen posicionamiento.

El nuevo OnPage SEO de 2012

* Traslapar la intención de búsqueda con el contenido de la página. Y justamente se debe agrandar lo más posible la intersección de lo que el usuario busca y lo que la página ofrece.

* Destacar el contenido que aparece en los resultados del buscador, los llamados snipets. Para optimizar el snipet se debe optimizar el metatag description. La frase clave debe ser atractiva para el usuario. Aquí también se pueden usar datos estructurados que últimamente Google los está mostrando gráficamente en la página de los resultados. Por ejemplo si se usa el tipo autor aparece la foto del autor. Una documentación sobre los microformatos o datos estructurados se puede encontrar en schema.org Para poder aparecer como autor en los resultados hay que realizar una verificación mediante Google+. Más información aquí. También la URL debe mostrar la marca y atraer para hacer clic. El ranking o posición en la página de resultados ya no es tan interesante ya que ahora con resultados más atrayentes y gráficos, el usuario no hace clic directamente en el primer resultado. Se deben evitar dominios muy largos y con muchas keywords (ver el EDM update más arriba).

* También la usabilidad de la página es importante: La descarga de la página debe ser rápida para no aburrir al usuario e incentivarlo a navegar por el sitio. Esto lleva consigo a un incremento del tiempo de permanencia, así como también a bajar el porcentaje de rebote. Aqui ya se ha hecho popular el termino WPO (Web Performance Optimization). Más sobre este tema en Google Developers.

* Incentivar al usuario a compartir el contenido de la página de manera fácil y sencilla en las diferentes redes sociales. Colocar botones y cosas llamativas para animar al usuario a compartir la página. Es decir hacerla social shareable o más compartible socialmente.

* Las técnicas del OnPage SEO clásico todavía tienen validez.

Así pues los SEOs se tienen que ir adaptando a estos nuevos tiempos y aprender nuevamente, aunque las cosas se van a poner cada vez más difíciles, sobre todo por que no se puede comprobar directamente y en forma rápida los efectos de los cambios realizados en una página web.

Via: SEOmoz