Como ya lo había mencionado en otro artículo, hoy día Google esta realizado su día de la prensa (Google Press Day). La agenda del día es la siguiente:

9:30 am

Welcome – Elliot Schrage

9:40 am

How We’re Doing and Where We’re Going – Eric Schmidt

10:10 am

A Search Technology Overview – Alan Eustace

10:30 am

Be Global, Act Local – Omid Kordestani

11:00 am

Break

11:25 am

Innovation: Many Shapes, Many Sizes – Jonathan Rosenberg & Marissa Mayer

12:15 pm

Executive Q&A

1:00 pm

Lunch

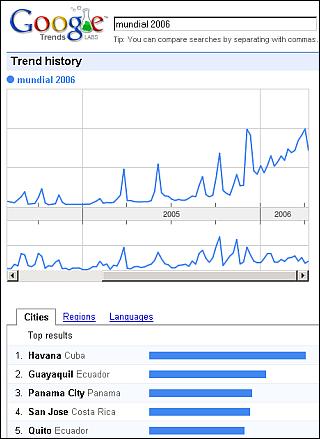

Uno de los primeros productos que se han presentado es Google Trends. Una herramienta interesante para analizar las búsquedas que hacen los usuarios del buscador en el transcurso del tiempo, ordenados en categorías, como ser por ciudad, región e idioma. Por ejemplo para las keywords mundial 2006 he obtenido los siguientes resultados:

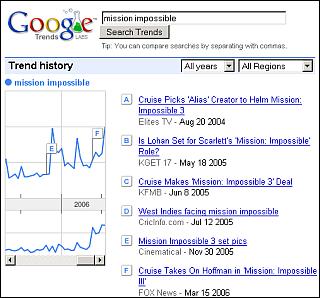

Una interesante función son los triggers o disparadores con las noticias que han generado los picos en el volumen de las búsquedas. Por ejemplo para la búsqueda mission impossible, he obtenido los siguientes resultados:

A pesar de que no se muestran detalles cuantitativos, Google Trends puede ayudar bastante a los SEOs a buscar las palabras mas usadas para sus proyectos.

A medida de que hayan mas novedades, como por ejemplo Google Health, estaré actualizando esta nota.

Actualización

Phillip Lensen esta haciendo una actualización en vivo de todo lo que esta sucediendo en el Google Day Press y descripiendo los nuevos productos que se estan presentando.

Matt Cutts también escribe sobre lo que sucede en el Google Press Day, y comenta las presentaciones desde un punto de vista tácnico.

Post de Marissa Mayer, Vice President of Search Products and User Experience en el blog oficial de Google.