Después de que los resultados del buscador de Google fueron duramente criticados por la prensa y la opinión publica en general (ver La manipulación de los buscadores es tema de conversación en las grandes esferas, Google search and search engine spam), Google ha reaccionado rápidamente con el cambio de su algoritmo y lo ha puesto a prueba en los resultados de los Estados Unidos.

Se trata de la llamada actualización Panda o también Farmer Update como la denominó Danny Sullivan debido a que esta actualización está dirigida a las granjas con contendido de baja calidad. Es decir sitios web que copian contenidos de otros o que escriben artículos de baja calidad solo con palabras claves competitivas para posicionarse en el buscador y así generar tráfico para monetizar su publicidad.

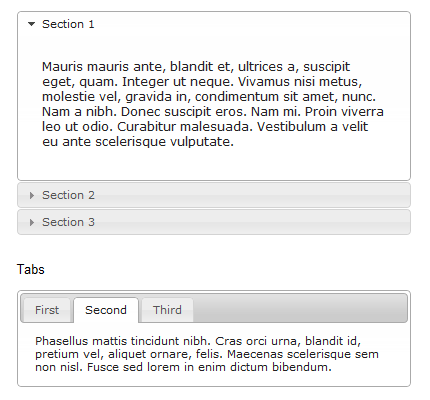

En esta ocasión, se han usado «algoritmos inteligentes» para encontrar a estos sitios web. Según Google se han usado clasificadores de documentos: En una primera instancia y en base a encuestas de usuarios o datos estadísticos se clasifica un conjunto de páginas en paginas verdes, las que están bien y páginas rojas, es decir aquellas que son de contenido de baja calidad. Con está información, los algoritmos inteligentes pueden aprender a clasificar por si solos cualquier otra página que el googlebot les presente.

Y para mejorar este nuevo algoritmo y poder comparar sus resultados con datos de los usuarios, Google creó inicialmente para Chrome una extensión que permite bloquear sitios en los resultados del buscador. Ahora, esta función también está disponible directamente en los resultados del buscador, por lo menos en los Estados Unidos. Así los ingenieros ahora tienen una forma más para alimentar o por lo menos poder comparar los resultados de su algoritmo de clasificadores de documentos.

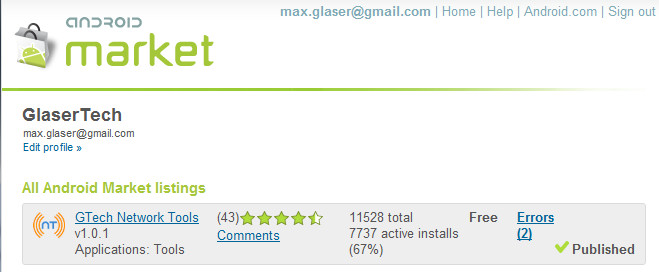

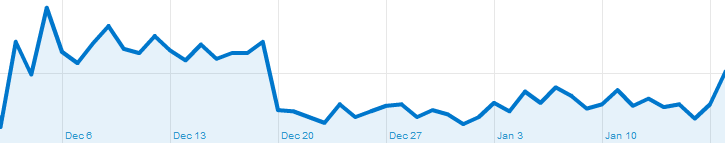

Según Google, este algoritmo solo ha afectado más o menos el 12% de las búsquedas en los Estados Unidos, aunque muchos webmasters creen que este cambio ha afectado a más del 40% de los sitios web grandes. Por ejemplo, en este artículo Four Sites Impacted By Google’s “Farmer Update” Speak Out 4 sitios conocidos hablan sobre la caída de su trafico después de la actualización Panda.

Cómo ya se sabe, los algortimos no son 100% eficientes y tampoco este de document level classifiers y con los sitios malos también han sido afectados muchos otros que según sus webmasters tienen contenido original y de calidad para sus usuarios. Por este motivo, Google ha abierto un hilo en el foro de ayuda de Google Webmaster para que los afectados se pronuncien y en una segunda fase, el algoritmo pueda ser mejorado.

Después de la actualización Panda los SEOs y webmasters han generado una infinidad de discusiones de cómo contrarrestar sus efectos. Se han dado todo tipo de consejos y han aparecido como siempre muchas teorías. Por ejemplo Greenlight aconseja a los webmasters a prepararse antes de que Panda se propague en forma global y en diferentes idiomas.

Un buen resumen sobre los efectos de la actualización Panda, lo dá Vanessa Fox en su nota sobre las lecciones aprendidas en el SMX West en el que da algunos consejos para evitar la penalización de Panda, habla del white hat cloacking, de link building y de cómo funcionan los reportes de spam de Google.

En lo que se refiere a la actualización Panda, lo más interesante es lo siguiente:

Bloquear contenido de baja calidad

Las páginas con bajo contenido también pueden afectar al ranking de otras páginas del sitio web. Todavía no está claro si es que la actualización Panda afecta solo algunas páginas o al sitio completo. En algunos casos, se han visto que sitios afectados todavía tienen páginas muy muy posicionadas para búsquedas del long tail.

Se consideran páginas de bajo contenido por ejemplo aquellas que hacen recesiones de usuarios de productos, pero inicialmente no tienen comentarios. Estas páginas contienen posiblemente la descripción de un producto que aparece en muchos otros sitios (contenido duplicado) y no se diferencia en nada de estos hasta que se llene de comentarios.

Por eso se aconseja bloquear estas páginas del rasterador usando < meta name=robots content=noindex > o en robots.txt

Otra posibilidad que ya se ha mencionado en otras discusiones es mover las páginas de bajo contenido a otro dominio.

Controlar la proporción anuncios / contenido

Matt Cutts ha comentado que tener publicidad en una página no reduce su calidad, pero una exageración si. Páginas con más anuncios que contenidos generan un experiencia de usuario muy pobre y pueden ser clasificadas como de bajo contenido.

Controlar la frecuencia de rastreo del googlebot

Ya es bien conocido que la frecuencia de rastreo del googlebot es una métrica que muestra la popularidad de un sitio en Google. Un sitio web saludable puede ser rastreado por el googlebot varias veces al día.

Vanessa aconseja revisar los logs del servidor web y ver qué páginas son rastreadas solo esporádicamente. Esto podría ser una señal de que esas páginas son consideradas por Google como de baja calidad.

Propagación a nivel internacional

Y finalmente algo que interesa a todos los SEOs y webmasters que no están en el mercado norte americano: Según Matt ya se están realizando pruebas con estos nuevos algoritmos a nivel internacional y se espera que en las próximas semanas estos cambios también se propaguen a los buscadores en otros idiomas.

Pero también indica que este tipo de contenido de baja calidad se observa principalmente en los Estados Unidos, por lo que esperan que el impacto de Panda internacionalmente sea mucho más bajo que en USA.

Esta acotación final es casi una buena noticia para los SEOs de todo el mundo. Pero de todas maneras creo que ya se tienen que estar preparando para evitar que sus páginas sean atrapadas por Panda.

Se debe revisar los sitios webs y seguir los consejos antes mencionados para evitar cualquier penalización.